Zeitreise durch die Welt der Speicherindustrie

Sie sind aus unserem Alltag nicht mehr wegzudenken, die Speichermedien in ihren vielfältigen Ausprägungen und Erscheinungsformen. Längst vorbei sind die Zeiten, als der deutsche Ingenieur Fritz Pfleumer 1932 die Vorarbeiten zur magnetischen Speicherung lieferte und daraus später das legendäre Magnetophon K1 der Firma AEG wurde.

Sie sind aus unserem Alltag nicht mehr wegzudenken, die Speichermedien in ihren vielfältigen Ausprägungen und Erscheinungsformen. Längst vorbei sind die Zeiten, als der deutsche Ingenieur Fritz Pfleumer 1932 die Vorarbeiten zur magnetischen Speicherung lieferte und daraus später das legendäre Magnetophon K1 der Firma AEG wurde.

In den Folgejahren wurden viele Erfindungen rund um das Thema magnetische Datenspeicherung gemacht. 1956 wurde die erste Magnetplatte Modell 350 von IBM in ein System IBM 305 RAMAC eingebaut – der Grundstein für einen beispiellosen Siegeszug der Magnetplatte war gelegt.

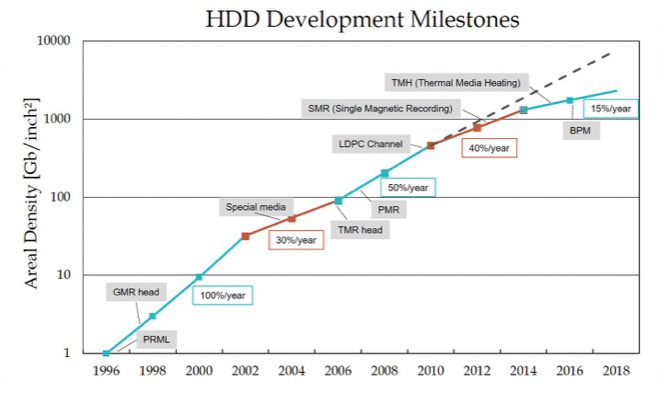

Zahllose technische Erfindungen und Neuerungen flossen seitdem in die Magnetplatte ein; so bekam der Physiker Peter Grünberg 2007 den Physik-Nobelpreis für die Entdeckung des GMR-Lesekopfes, bei dem sich der magnetische Widerstand in Abhängigkeit von der Magnetisierungsrichtung verändert. Nicht nur der Lesekopf, auch die magnetisierbaren Oberflächen der rotierenden HDD-Scheiben, auch „plattern“ genannt, erfuhren zahllose technische Neuerungen wie die Ablösung der seit den 60er-Jahren bekannten LMR (Longitudinal Media Recording, Magnetisierung der „bits“ in Längsrichtung der Scheiben) durch das PMR (Perpendicular Media Recording) genannte Verfahren, bei dem die Datenbits quasi senkrecht zur Scheibenoberfläche gespeichert werden.

Obwohl die Entwicklung der elektronischen Komponenten einer HDD weitestgehend den physikalisch-chemischen Errungenschaften hinterher„hinkte“, war die Entwicklung eines besonders leistungsstarken HDD-Datenkanals in den 90er-Jahren, des sogenannten PRML Channel (Partial Response Maximum Likelihood), ein ebenso bemerkenswerter Meilenstein in der Entwicklung der Speichermedien. Wesentliches Merkmal des PRML-Datenkanals ist, dass die zum Teil extrem schwachen analogen Signale der Magnetscheiben elektrisch aufbereitet nach „maximal wahrscheinlichen“ Dateninhalten interpretiert werden und somit die traditionelle Methode „Peak Detect“, bei der feste Amplitudenwerte zur Datenerkennung Voraussetzung waren, abgelöst wurde.

Es zeigte sich, dass immer dann, wenn eine neue Technologie nicht mehr weiter gesteigert werden konnte und alle Methoden einer Prozessoptimierung im Sinne einer kleineren Prozessstreuung („kleine Sigmas“) ausgereizt waren, die Speicherindustrie mit einer neuen genialen Idee aufwartete. So wurden um das Jahr 2000 herum erste Datenköpfe als „TMR Heads“ ausgeführt, bei denen ein Tunnel-Effekt („Tunneling MagnetoResistance“) dazu benutzt wurde, um die Änderung des Lesewiderstandes der Datenköpfe und damit die Empfindlichkeit beim Lesevorgang zu optimieren.

Die Fülle der faszinierenden Erfindungen ist schier unglaublich, daher können an dieser Stelle bei Weitem nicht alle genannt werden. Grenzen der Physik wurden immer wieder „gedehnt“ und weiter „hinausgeschoben“. Wurden die Signale der rotierenden Scheiben zu schwach, verringerte man kurzerhand durch Meisterleistungen der Mechanik die Flughöhe der Datenköpfe, und als das nicht mehr ausreichte, erhöhte man die mechanische Robustheit der Köpfe, sodass sogar HDD Designs auf den Markt kamen, bei denen der Kopf im Betrieb auf dem Medium „schliff“. Allerdings hatte dieser „Schleifkopf“ eine überschaubare Marktakzeptanz.

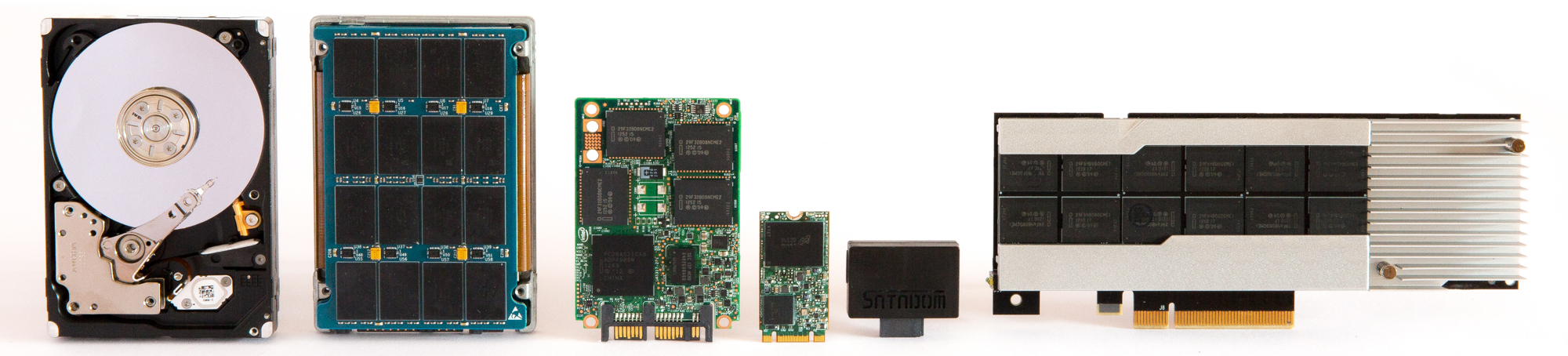

Seit den 80er-Jahren des letzten Jahrhunderts entwickelte sich die Speicherindustrie aber auch in eine fundamental andere Richtung der Datenspeicherung: Flash-basierte Speicherzellen wurden genutzt, um Dateninhalte ebenso wie bei der Magnetplatte nicht „flüchtig“ zu speichern, die SSD (Solid State Disk) war geboren.

Auch diese Technologie hatte und hat ihre Herausforderungen. So „nutzen“ sich je nach „Segment“ die SSDen bei starker Beanspruchung, man spricht hier von der „Schreiblast“, zum Teil sehr schnell ab. Verschiedene Designs der SSDen (SLC, MLC, eMLC und TLC sind hier die Schlagworte) halten einer gegebenen Kundenanwendung unterschiedlich lange stand.

Die Versuche der Speicherindustrie, mit Maßeinheiten wie TBW (TeraBytes Written) oder DWPD (Drive Writes Per Day, d. h., wie viele komplette Beschreibvorgänge sind bei der SSD pro Tag möglich) die Abnutzung einer SSD für den Endverbraucher kenntlich zu machen, wurden sehr schnell unübersichtlich. Teil des Dilemmas war die zunächst fehlende Standardisierung für die „ENDURANCE“ genannte Abnutzungsqualität einer SSD, da helfen dann auch die farbenprächtigen Auswertungstools der Hersteller recht wenig.

Waren SSDen zu Beginn noch sehr teuer und lagen ihre Kapazitäten noch weit hinter denen handelsüblicher Magnetplatten zurück, wird heutzutage ein Großteil des benötigten industriellen Speicherbedarfs durch die SSD abgedeckt. Die gegenüber einer HDD vielfach höhere I/O-Performance und die relativ geringe Leistungsaufnahme sind dabei die treibenden Faktoren.

Ähnlich dem Verdrängungsmarkt bei den Magnetplatten, der seinen Höhepunkt um die Jahrtausendwende erreicht hatte, hat dieser Mechanismus sehr früh auch bei den SSDen eingesetzt und ist heute bei Weitem noch nicht abgeschlossen.

Eine sehr starke „Segmentierung“, welche SSD für welche Anwendung geeignet ist, hat mit der Marktreife der SSD begonnen. Was die Köpfe und Media bei der HDD sind, ist bei einer SSD die verwendete Lithografie.

Die Belichtung der Speicherstrukturen (photolithografischer Prozess), bei der auf kleinstem Raum (15 nm, 13 nm und zum Teil noch kleineren Abmessungen) Dateninhalte gespeichert werden können, ist einer der wesentlichen Designfaktoren einer SSD, die zugehörige Lithografie entscheidet über die Herstellungskosten.

Neben den SSDen wurden in den letzten Jahren viele weitere Möglichkeiten einer „nichtflüchtigen“ oder persistenten Datenspeicherung entwickelt und vorangetrieben. So werden ReRam als mögliche Ablöse der Flash-Speichertechnologie entwickelt, bei denen auf einem Dielektrikum durch Anliegen einer relativ hohen Spannung die isolierte Schicht gezielt leitend gemacht wird.

Artverwandt zum ReRAM oder RRAM wurde PCM (Phase Change Memory) entwickelt, bei dem die Änderung bestimmter kristalliner Strukturen und Formen zur Speicherung ausgenutzt wird.

Die vor Kurzem als „3D XPoint“ bekannt gewordene Technologie kann in diesem Kontext als eine „Spielart“ von PCM angesehen werden, jedoch sehr viel komplexer in ihrer Funktion und dem verwendeten Material.

Eine CBRAM (Conductive bridging RAM) genannte Technologie nutzt eine andere Art der gelenkten Leitfähigkeit des elektrolytischen Materials aus.

Beinahe täglich erscheinen Meldungen zu neuen Speicherwerkstoffen und -verfahren.

Abschließend sei noch eine Weiterentwicklung der SSD erwähnt, deren konzeptionelle Idee es ist, Flash Memory „immer enger“ der CPU eines Computersystems anzunähern:

PCIe SSDen und NVDIMMs sind, wie der jeweilige Name schon vermuten lässt, steckbare Speicherbausteine für den jeweiligen System-PCIe-Bus bzw. die DIMM Ranks, mit Anbindung an den Systembus.

Dieser zugegeben sehr rudimentäre Streifzug durch die Welt der Speichertechnologien und deren Entwicklung mag dennoch genügen, um einen Eindruck von der ungeheuren Dynamik dieser Technologiesparte zu vermitteln.

Viele bahnbrechende Entwicklungen und Erfindungen gerade auch im Bereich der Produktionstechnik wurden hier nicht erwähnt, haben aber allesamt dazu beigetragen, dass der Speichermarkt einer hohen Änderungsgeschwindigkeit unterliegt, wobei manchmal auch technische Risiken mangels Langzeiterfahrung stark unterschätzt werden.

In diesem Zusammenhang versteht sich TECODI als Vermittler zwischen technischer Herausforderung und dem permanenten Kostendruck. So sind billige und preiswerte Speicherlösungen durchaus möglich und praktikabel. In vielen Fällen ist der Unterschied fließend und für den Kunden nicht immer unmittelbar einsichtig.

TECODI war seit den späten 80er-Jahren des zwanzigsten Jahrhunderts in all diese Entwicklungszyklen der Speicherindustrie involviert. Das Ergebnis ist ein breites, aber auch tiefes Verständnis für die jeweiligen Herausforderungen einer neuen Technologie und die damit einhergehende Anforderung an die Systemumgebung.

All die beschriebenen neuen Speichertechnologien haben eines gemeinsam:

Jeder technische Nutzen in der Speicherindustrie hat auch seine technische Herausforderung, die in der Kundenumgebung beherrscht werden muss.

TECODI – von Anfang an dabei.